Cet article fait partie de ma série Comment prendre une bonne photo, et est la suite directe de cet article : COMMENT PRENDRE UNE BONNE PHOTO : L'EXPOSITION

Dans l'article précédent, on a vu comment exposer correctement, c'est à dire à ne pas cramer les hautes lumières dans le fichier raw.

Cependant, des logiciels de développement raw comme Lightroom/CameraRaw ou CaptureOne permettent de "récupérer" des informations dans les hautes lumières qui seraient cramés.

Mais si c'est le cas, pourquoi s'embêter à bien exposer ? Comment algorithme marche-t-il, et à quel point peut-il vraiment récupérer vos erreurs ? C'est ce qu'on va voir aujourd'hui.

Il y a surex, et il y a SUREX.

Revenons à l'image de l'article précédent, où j'ai pris une exposition surexposée en testant les limites du zebra réglé sur 107+.

On peut y voir que certaines couches sont surexposées, mais pas toutes : uniquement les couches G1 et G2.

Parlons rapidement des couches, car c'est de ça dont il va beaucoup s'agir dans cet article.

A moins que vous ayez un appareil très particulier, votre appareil utilise une matrice de bayer : c'est à dire qu'au lieu d'enregistrer les valeurs pour le rouge, le vert et le bleu pour chaque pixel (les trois couleurs primaires à partir desquelles vous voyez une image en couleur sur un écran), votre appareil n'enregistrera qu'une seule de ces couleurs par pixel, et devinera les couleurs manquantes à partir des pixels à proximité. Ainsi, le capteur est organisé ainsi : il y a deux pixels (ou plutôt photosite, mais pour simplifier on va dire ici que c'est la même chose) verts pour un pixel rouge et un pixel bleu. Pourquoi ? Parce que notre oeil est très sensible au vert, et que pour des raisons physiques c'est aussi à partir du vert qu'on va faire une mesure de luminosité. Le plus important, c'est qu'un raw a quatre couches : deux de vert, une de rouge, une de bleu.

Or, toutes ces couches n'étant pas égales (à moins de prendre un sujet parfaitement monochrome, qui dans ce cas là aurait des valeurs égales pour chaque couche), il peut arriver, comme ici, qu'une couche ou plusieurs soit "pleine" sur certains de ses pixels, mais que d'autres, non.

C'est là que les algorithmes de récupération des hautes lumières travaillent : à partir des informations non cramés, il va essayer de deviner les valeurs non cramés qui manquent. Spoiler alert : c'est pas brillant.

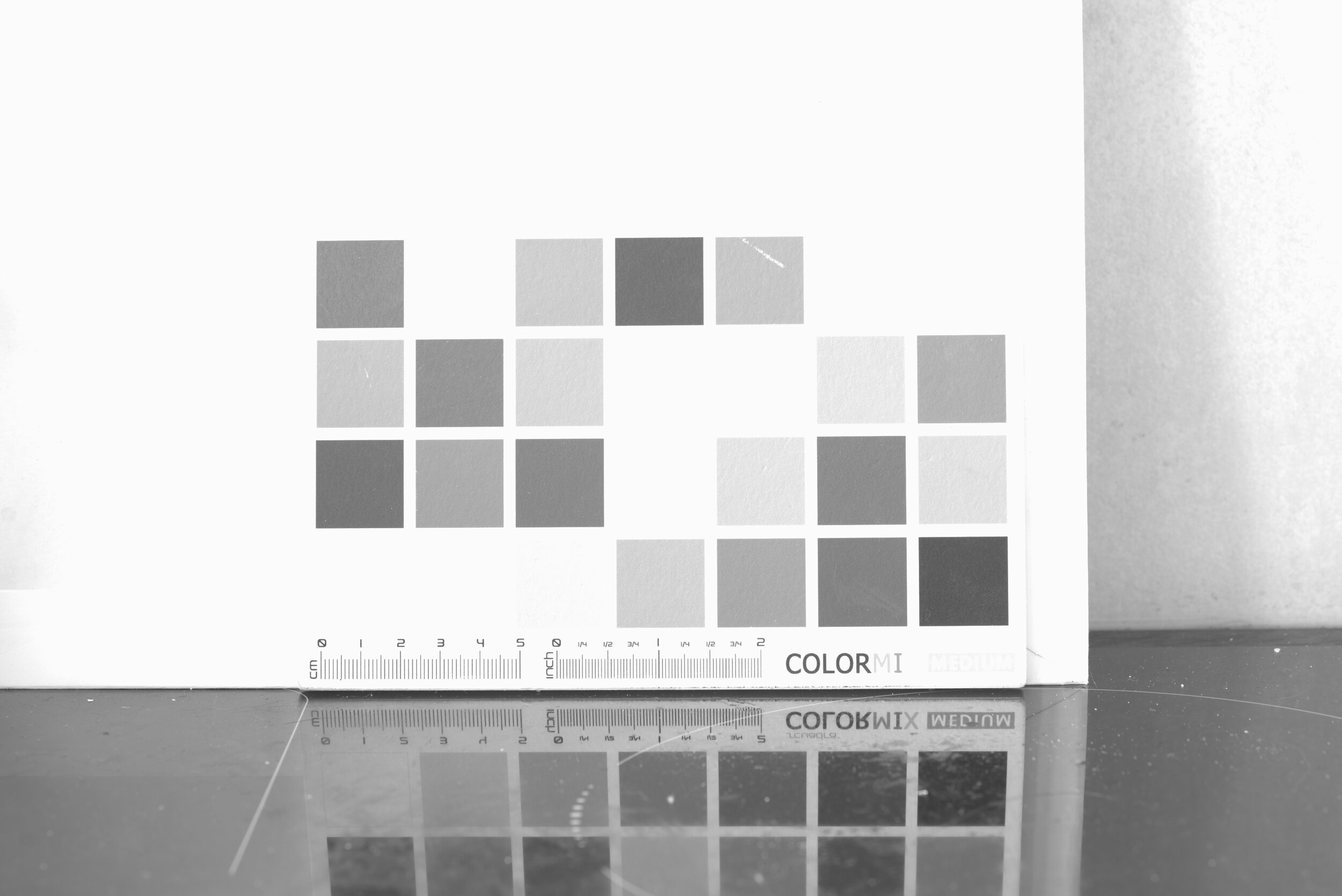

Pour démontrer cela, j'ai pris à nouveau ma charte de couleur en photo, plusieurs fois. Sur le côté gauche de mes exemples, vous retrouverez une photo correctement exposée de la charte. Sur le côté droit, une photo surexposée, dont l'exposition a été baissée pour essayer de récupérer les informations, et avoir une luminosité égale à la photo bien exposée. Observons tout d'abord les couches séparément.

Couche Bleue :

Couche Rouge :

Couches Vertes :

Il est assez facile de distinguer sur les couches vertes quels sont les patchs de couleurs surexposés : vous les voyez en haut à gauche, au centre, et en bas à gauche. Ils sont tellement cramés qu'on ne les distingue plus du blanc de la charte.

Regardons d'abord le carré en haut à droite.

On voit bien que, si le carré n'est plus blanc une fois toutes les couches superposées, la couleur n'est plus la même : l'algorithme a bien essayé de compenser le manque d'information, mais cela ne peut être qu'une approximation mathématique et, on le voit bien, elle s'éloigne de la réalité.

En revanche, les deux patchs de couleur du dessous, n'étant pas cramé sur aucune des couches, gardent leur couleur correcte.

Passons ensuite à un cas encore plus extrême : ici, le violet un peu pastel se retrouve être un gris complètement désaturé. En effet, comme il y a peu de vert dans le violet, le fait d'en avoir beaucoup trop brouille complètement les pistes du logiciel. Ainsi, au lieu de recréer la bonne valeur de couleur (R : 211, V : 189, B : 196, on voit bien que le vert est bien plus faible que la couche rouge), il va considérer que c'est une couleur avec beaucoup de vert, et donner ces valeurs : R : 204, V : 205, B : 197

On voit bien que la couche de rouge et la couche de bleu n'ont quasiment pas été affectées (puisque pas cramés), mais la couche verte, elle, est bien trop haute ! Les valeurs sont très proches les unes des autres, ce qui donne cette faible saturation.

Toujours plus fort

Allons encore plus loin.

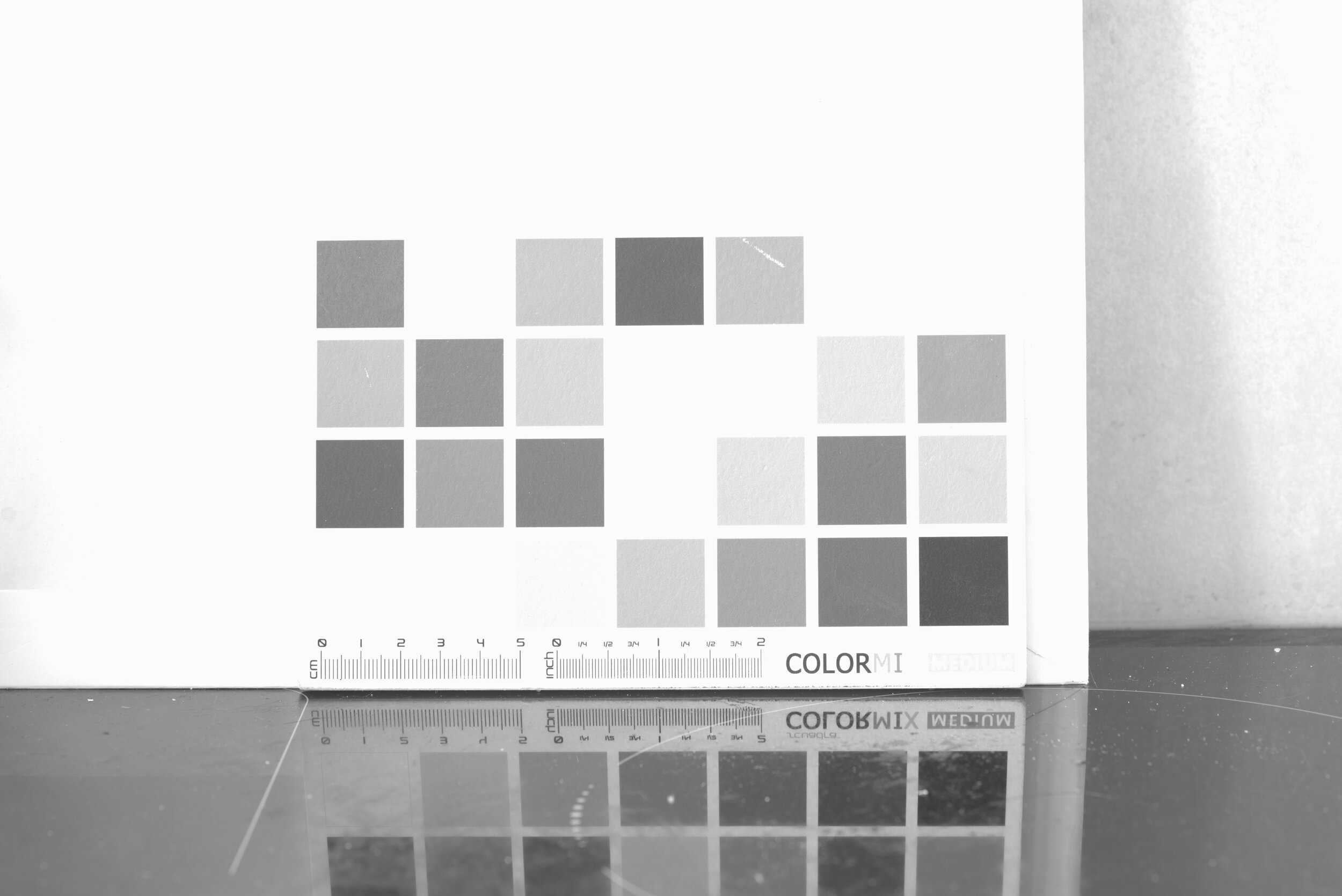

Jusque là, je faisais la comparaison entre une image bien exposée et une autre exposée 2,66 diaph au dessus. Nous allons maintenant comparer la même image avec une autre surexposée de 4 diaph !

La voici, corrigée par le logiciel, c'est a dit avec l'exposition baissée de 4 diaph.

Il n'y a même pas besoin de mettre les images cote à cote : ici, il manquait tellement d'information au logiciel que les trois carrés en bas à gauche (et d'autres) ont tout simplement disparus ! C'est presque un tour de magie : reflétés plus sombres par ma plaque de cuisine (que j'aurais pu mieux nettoyer pour ces tests, mon objectif macro ne pardonne rien), ils sont bien visibles, et complètement invisibles au dessus.

De même, on voit que les autres couleurs ne sont pas en reste : si toutes les couches n'ont pas été surexposées partout, on repère bien un énorme changement de couleur pour la plupart.

Conclusion : il n'y a qu'un dieu en photographie, c'est la lumière.

Oubliez toutes les promesses de computional photography et autres prophéties miracles : si les logiciels de retouches peuvent rendre énormément de service, aucune ne vous rendra les informations de votre image surexposée. Il y a beaucoup de choses rattrapables en post production (et je dirais lesquels dans de prochains articles), la surexposition n'est est malheureusement pas une.

Il est donc encore temps de revenir à mon article précédent et de bien régler votre appareil/calculer la déviation de votre cellule. Ainsi, vous serez sûr d'exposer au mieux vos images, et vous pourrez prendre les photos que vous avec en tête. N'attendez pas un nouveau saut technologique : c'est déjà possible.

Quelques liens pour aller plus loin :

https://www.fastrawviewer.com/blog/how-to-use-the-full-dynamic-range-of-your-camera

https://www.fastrawviewer.com/blog/determining-practical-dynamic-range